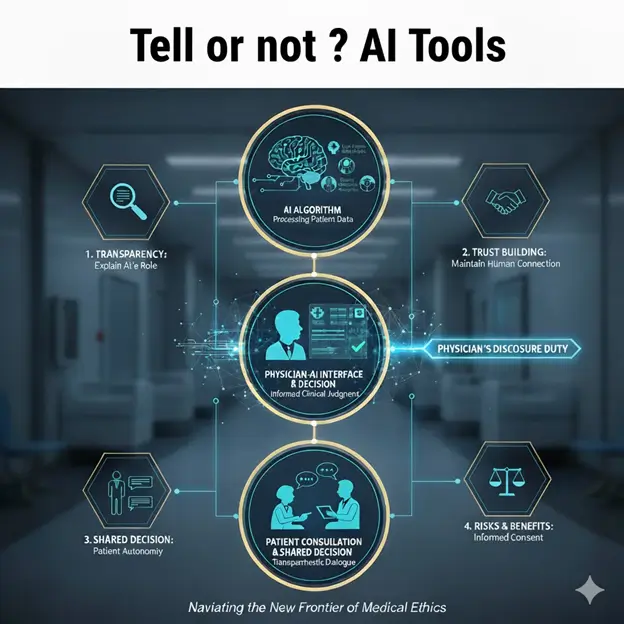

AI就在你身邊,但你有權知道

隨著科技進步,人工智慧(AI)已經悄悄走進醫院,成為醫師診斷和治療的「隱形幫手」。從判讀X光片、協助開立藥物處方,到整理病患的電子郵件回覆,AI大大提升了醫療效率。

但是,AI的廣泛應用,也帶來了一個迫切的倫理問題:當醫院使用AI工具來輔助醫療決策時,病人是否需要被告知?

根據《美國醫學會雜誌》(JAMA)上近期一篇重要文章,傳統的「知情同意」流程,通常只要求告知病人關於治療的重大資訊,像是藥物副作用或手術風險,對於背後的「輔助工具」則常省略。然而,多項調查顯示,大多數美國成年人(超過六成)都明確表示,如果他們的醫療過程中使用了AI,他們非常希望能被告知。

面對病人的期待、法律的責任以及維持醫病關係的信任,醫療機構不能再視而不見。這篇文章將根據JAMA提出的「AI披露框架」,用簡單易懂的方式,說明醫院該如何決定何時「告知」、何時「尋求同意」,以及該如何溝通。

難題:不能「一刀切」地全部告知

你可能會想,既然大家都想知道,那乾脆全部都說不就好了?

事實上,全面告知每一項AI工具既不切實際,也可能帶來反效果:

- 資訊過載 (Information Overload): 醫院裡可能有數十種AI工具在運作。如果連讀心電圖的AI都要特別解釋,病人會被過多、不重要的細節淹沒,反而可能忽略真正關鍵的資訊。

- 破壞信任 (Trust Erosion): 有研究指出,即使AI生成的電子郵件回覆比真人寫的更具同理心,但當病人被告知「這是AI寫的」,他們對回覆的滿意度反而會降低。過度揭露可能適得其反,讓人懷疑醫療專業的價值。

- 潛在的數據偏差 (Algorithmic Bias): 如果醫院給予病人「選擇退出(Opt-Out)」的權利,不讓AI使用他們的數據,長遠來看可能會導致AI訓練數據的廣泛性不足,影響AI的準確性,最終傷害到更廣大病患的公共健康。

因此,專業的醫療領導者必須有一個更精準、更有策略的標準,來決定AI披露的程度。

決策框架:判斷「該不該說」的兩大關鍵

JAMA的框架告訴我們,判斷是否要對病人披露AI,必須回答兩個核心問題:「這項AI風險高不高?」 和 「病人有沒有選擇權?」

關鍵一:AI帶來的「身體傷害風險」有多高?

這項評估需要考慮三個要素的組合:

- AI出錯的可能性: 這個AI模型本身的準確度如何?錯誤率高不高?

- 醫護人員能攔截錯誤的可能性: 即使AI出錯,負責監看的醫師或護理師,有多大的機率能夠及時發現並修正這個錯誤?(人會因為過度依賴AI而產生「自動化偏差」,降低警覺性。)

- 錯誤造成的傷害有多嚴重: 如果AI出錯且沒被攔截,對病人身體造成的後果是輕微的(例如:小小的用藥提醒錯誤),還是會造成嚴重、甚至立即性的傷害(例如:手術中的判斷失誤)?

結論: 三個要素的相乘越高,醫院的披露義務就越重。

- 舉例: 一個AI手術導航工具,即使出錯的機率很低,但一旦出錯,後果是立即且嚴重的,那麼這個風險值就很高,需要嚴格的披露。

關鍵二:病人可以行使的「自主權(Agency)」有多少?

自主權是指病人能否在被告知後,採取行動來促進自己的最佳利益。這分為兩種層次:

1. 能否退出 AI 輔助的治療?(選擇權)

- 需要同意(Consent): 如果病人有實際的、臨床上可行的替代方案。

- 例如: 醫院引進了一台AI導航的非自主手術機器人。病人可以選擇接受傳統的非機器人手術。此時,病人有高自主權來選擇治療方式,醫院應「尋求同意」。

- 不用特別告知(Neither): 如果病人沒有任何合理的替代選擇。

- 例如: 醫院的後勤管理AI,根據你的手術時間預測需要準備多少血液庫存。病人不能要求醫院關閉這項營運效率的AI。病人沒有選擇權,醫院不用特別告知。

2. 能否改變行為來維護自身利益?(可行動的意識)

- 需要告知(Notification): 即使不能退出AI的使用,病人得知後是否能做出有益的反應?

- 例如: 醫師的門診紀錄摘要是由AI自動生成的。病人被告知後,就會更仔細檢查電子病歷,看是否有AI產生的遺漏或錯誤。此時,告知能促使病人採取行動,醫院應「通知」。

實踐:醫院的三種「告知」等級

結合風險和自主權,醫療機構可以將AI工具的使用劃分為三種等級,並制定相對應的披露政策:

| AI 使用情境 | 風險評估 | 自主權評估 | 建議披露等級 | 實務操作原則 |

|---|---|---|---|---|

| 高風險/高自主權 | 高(錯誤可能造成嚴重傷害) | 有(病人可選替代方案) | 尋求同意(Consent) | 在治療前必須提供清晰、簡潔的資訊,讓病人簽署同意書,確保他們理解並接受AI的介入。 |

| 中風險/可行動自主權 | 中低(錯誤可修正,但仍需注意) | 有(病人可檢查或質疑AI結果) | 通知(Notification) | 透過頁腳文字、網站公告或簡單聲明,告知AI參與了流程,但不需病人簽名同意。重點在透明化。 |

| 低風險/無自主權 | 低(錯誤影響輕微且容易被修正) | 無(與病人治療選擇無關) | 不用特別告知(Neither) | 將其視為標準的內部運營效率工具,不特別在護理點提及,以避免資訊干擾。 |

溝通重點:如何「說」才有效?

當醫院決定必須告知時,訊息的呈現方式是關鍵。披露內容必須使用「簡單、具體的語言」,並包含以下要素:

- AI工具的用途: 說明AI的具體功能(例如:AI協助預測感染風險,而非AI進行診斷)。

- 人類醫師的角色: 強調AI僅為輔助,最終的判斷和決策仍由醫師負責。

- 機構的監測機制: 說明醫院如何定期檢查和監測這個AI工具的性能,特別是對不同群體病人的表現,以確保公平和安全。

- 病人能採取的行動: 清楚說明病人是否可以選擇退出,或在得知後可以要求做哪些進一步的檢查或詢問。

治理是永續發展的KPI

AI在醫療中的應用是大勢所趨,它承諾帶來更高的效率和更精準的臨床結果。然而,負責任地部署AI,不僅是技術層面的挑戰,更是一種經營倫理與戰略治理。

對於醫療機構的領導者和投資者來說,一個穩健的AI披露框架,不僅是遵守法律和倫理的義務,更是維護病患信任的關鍵指標(KPI)。透過這種結構化的「風險與自主權」評估,醫院能夠避免「全有或全無」的透明度困境,在提供最佳臨床照護的同時,確保病人能夠在充分知情的基礎上,行使他們對自身醫療的選擇權。維護信任,是AI時代醫療創新最可持續的投資。

Mello MM, Char D, Xu SH. Ethical Obligations to Inform Patients About Use of AI Tools. JAMA. 2025;334(9):767–770. doi:10.1001/jama.2025.11417

本文章根據《美國醫學會雜誌》(JAMA)發表的「Ethical Obligations to Inform Patients About Use of AI Tools」文章內容,使用Gemini Pro 2.5 進行專業性解讀與簡化說明。